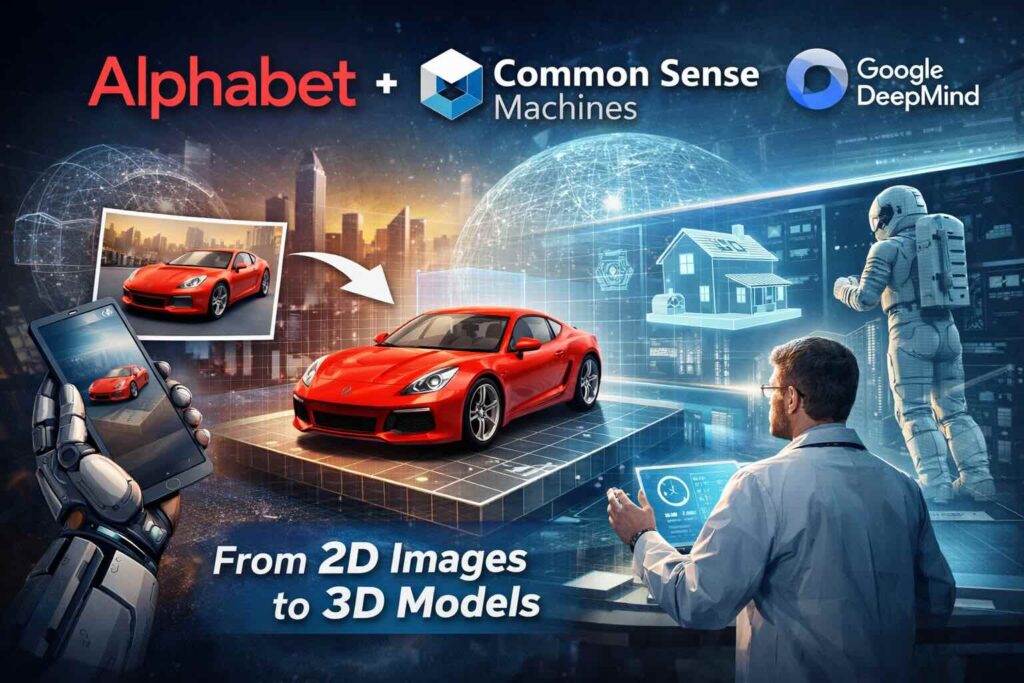

Alphabet compra Common Sense Machines

Alphabet, la holding che controlla Google, ha acquisito Common Sense Machines, Inc., una startup con sede a Cambridge (Massachusetts) che sviluppa modelli di intelligenza artificiale capaci di generare asset 3D a partire da immagini 2D. Secondo le informazioni riportate da fonti finanziarie riprese da più testate, l’operazione risulta chiusa il 24 gennaio 2026; il valore dell’accordo non è stato comunicato pubblicamente.

Chi è Common Sense Machines e perché interessa

Common Sense Machines (CSM) nasce nel 2020 con un obiettivo tecnico preciso: ridurre il “salto” tra contenuti visivi (foto, reference, immagini) e geometrie 3D utilizzabili. Nel momento dell’acquisizione, la società risulta essere una realtà piccola (ordine di grandezza: circa una dozzina di persone, a seconda delle fonti pubbliche), con un profilo più vicino a un laboratorio di ricerca e ingegneria che a un’azienda di prodotto “di massa”. Le ricostruzioni disponibili indicano anche un percorso di finanziamento limitato: raccolta di capitali nell’ordine di 10 milioni di dollari e una valutazione precedente riportata intorno a 15 milioni di dollari (dati citati da più fonti, non sempre con lo stesso livello di dettaglio).

La tecnologia: dal 2D al 3D (asset pronti per pipeline real-time)

Il punto tecnico di CSM è la generazione (o ricostruzione) di oggetti 3D partendo da input come immagini 2D. In pratica, il problema non è “solo” produrre una forma plausibile, ma arrivare a un risultato che sia utile nelle pipeline: mesh coerente, dettagli credibili, e (quando possibile) materiali/texture impostati in modo compatibile con i workflow di produzione digitale. Questo tipo di conversione è un collo di bottiglia classico: anche quando l’immagine è di qualità, trasformarla in un modello 3D pulito richiede tempo (modellazione, retopology, UV, texturing, rigging se serve). È qui che l’AI prova a comprimere tempi e costi, spostando parte del lavoro da attività manuali a una generazione guidata da dati.

Il legame con Google DeepMind e la linea “world models”

Tra gli elementi citati pubblicamente c’è la figura di Tejas Kulkarni, indicato come co-CEO e con un passato da ricercatore in Google DeepMind prima di co-fondare la startup. L’integrazione organizzativa non è stata dettagliata in modo ufficiale (almeno nelle fonti aperte consultate), ma la lettura industriale è abbastanza lineare: portare in casa un team focalizzato su rappresentazioni 3D e ricostruzione spaziale si incastra bene con l’interesse di DeepMind per sistemi che apprendono e simulano aspetti dell’ambiente fisico, spesso descritti come “world models”. DeepMind definisce i world models come sistemi capaci di usare una comprensione del mondo per simulare come un ambiente evolve e come le azioni lo modificano; in questo quadro, il 3D (coerente e “stabile”) è un mattone utile perché collega visione e geometria.

Perché questa acquisizione conta per il 3D (anche oltre il gaming)

La generazione di asset 3D da immagini non serve solo a videogiochi o VFX. In ottica manifatturiera e stampa 3D, il potenziale è più “a valle”: accelerare la trasformazione di un reference (foto di un componente, immagini di un concept, cataloghi) in un modello che poi può essere raffinato e validato. Non significa sostituire CAD parametrico o simulazione ingegneristica, ma può ridurre il tempo necessario per arrivare a una prima geometria esplorabile, utile per: concept di prodotto, mockup, personalizzazioni estetiche, e anche per flussi di creazione contenuti destinati a e-commerce 3D/AR (dove servono molti modelli in tempi brevi). Questa è una delle ragioni per cui la “comprensione spaziale” è diventata un tema trasversale: AR/VR, robotica, contenuti interattivi e, in parte, manifattura digitale condividono il bisogno di passare da pixel a struttura.

Il contesto competitivo: non è l’unico approccio al “text/image-to-3D”

Negli ultimi anni sono aumentate le piattaforme e i modelli che propongono generazione 3D da testo e immagini. Alcuni operatori si posizionano su produzione rapida di modelli per creator e team, con enfasi su esportazione verso motori real-time e su elementi come texture PBR o ottimizzazione delle mesh; altri arrivano dal mondo della ricostruzione 3D e cercano di unire fotogrammetria, generazione e tool di rifinitura. In parallelo, anche la ricerca accademica e industriale continua a spingere su pipeline end-to-end per asset “game-ready”, segno che il problema non è risolto in modo definitivo e che qualità/controllabilità restano il vero discrimine.

Cosa non è stato detto (e cosa osservare nei prossimi mesi)

Le informazioni pubbliche disponibili non includono il prezzo dell’operazione, né un piano ufficiale su prodotti, API o roadmap. Proprio per questo, i segnali da monitorare sono più indiretti: assorbimento del team in gruppi dedicati a modelli multimodali/spaziali, eventuali demo su conversione 2D→3D integrate in tool Google, e l’emergere di casi d’uso legati a contenuti 3D per XR o a simulazione (robotica, ambienti virtuali). Se Alphabet ha comprato una società piccola, la scommessa sembra meno su un prodotto “finito” e più su competenze e ricerca applicata per rappresentazioni tridimensionali coerenti.